Akustische Phonetik

Die akustische Phonetik ist ein Teilgebiet der Phonetik, das sich mit der Akustik menschlicher Sprachlaute beschäftigt. Die akustische Phonetik befasst sich mit der Beschreibung der sprachlichen Laute als Schallschwingungen, wie sie von Sprecher zum Hörer übertragen werden. Der Untersuchungsbereich der akustischen Phonetik befindet sich damit in dem Bereich nach der Artikulation durch den Sprecher und vor der Signalaufnahme durch das Ohr des Hörers.

Da Sprachlaute aus physikalischer Sicht aus Schall bestehen, kann die akustische Phonetik für die Beschreibung von Sprachlauten auf physikalische Größen wie Frequenz und Amplitude zurückgreifen, die aus der Akustik stammen. Die akustische Phonetik verwendet ferner technische Geräte wie Spektografen, um Sprachlaute visuell darzustellen. Wichtige visuelle Darstellungen von Sprachlauten sind das Oszillogramm, das die Frequenz und Amplitude von Schallwellen über die Zeit abbildet. Sonagramme, eine in der Phonetik übliche Spektralanalyse, dienen unter anderem dazu, Vokale als Frequenzbereiche erhöhter Intensität zu identifizieren.

Inhaltsverzeichnis

Geschichte

Während die Anfänge der Phonetik über 2000 Jahre alt sind, ist die akustische Phonetik ein relativ junge Teildisziplin. Mit dem Aufstieg der Naturwissenschaften in der Neuzeit entstanden erst die Voraussetzungen für die akustische Phonetik als naturwissenschaftliche Disziplin, die Ergebnisse und Methoden aus der Akustik und Mathematik nutzt. Ein wesentlicher früher Beitrag war z. B. die Schwingungslehre, mit der der Mathematiker Leonhard Euler gegen Ende des 18. Jahrhunderts die akustischen Eigenschaften von Vokalen genauer zu beschreiben versuchte.

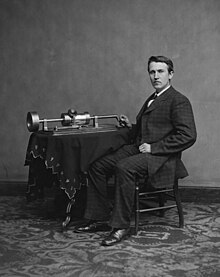

Ein Durchbruch für die Erforschung der akustischen Eigenschaften der sprachlichen Laute erfolgte im 19. Jahrhundert, als technische Apparate wie der Phonograph von Thomas Alva Edison zur Verfügung standen. Mit dem Phonographen konnte Schall, also auch sprachliche Laute, aufgezeichnet und wiedergegeben werden. Jean-Pierre Rousselot gehörte zu den Pionieren der Sprachaufzeichnung für wissenschaftliche Zwecke und kann als einer der Gründerväter der Phonetik als Wissenschaftsdisziplin genannt werden. Ludimar Hermann gelang es ferner 1889 und 1890 mit Hilfe mathematischer Prinzipien Stimm- und Lautkurven zu analysieren. Auf Hermann geht auch der Begriff Formant zurück, die Konzentration akustischer Energie in einem Frequenzbereich, die z. B. für die Beschreibung von Vokalen wesentlich ist.

Mit der Entwicklung der Elektroakustik ab den 40er Jahren des 20. Jahrhunderts standen der akustischen Phonetik technische Geräte wie der Sonagraf zur Verfügung, mit denen Laute visuell dargestellt und analysiert werden können. Mit dem Aufkommen von Computern sind neben die klassischen Geräte der akustischen Phonetik wie der Oszillograph und der Sonagraph Werkzeuge der digitalen Signalverarbeitung in den Vordergrund getreten. In der Sprachtechnologie haben die automatische Spracherkennung und die Sprachsynthese entscheidende Fortschritte gemacht. Durch die Verfügbarkeit von Personal Computern und freier Software wie Praat ist es ferner wesentlich einfacher und preisgünstiger geworden, phonetische Analysen durchzuführen.

Grundlegende Themen und Fragestellungen

Akustische Grundlagen

Die Grundlagen der akustischen Phonetik stammen aus einem Teilbereich der Physik, der Akustik. Sprachlaute sind aus der Sicht der Physik Schallwellen, die vom Kehlkopf über den Vokaltrakt (Rachen-, Mund- und Nasenraum) wandern und schließlich über die Luft vom Mund des Sprechers zum Ohr des Hörers übertragen werden. Die Schallwellen lassen sich mit den Mitteln der Akustik messen und beschreiben.

Schallwellen sind Druck- und Dichteschwankungen, die sich in der Luft bei einer Temperatur von 20 °C mit einer Schallgeschwindigkeit von 343 Metern pro Sekunde ausbreiten. Diese minimalen Luftdruckschwankungen sind für das menschliche Ohr hörbar. Schallwellen können mit physikalischen Größen wie Frequenz und Amplitude beschrieben werden. Die Frequenz ist die Anzahl der Schwingungen der Schallwelle pro Sekunde, und die Tonhöhe eines Tones wird in der Praxis mit der Frequenz eines Tones gleichgesetzt. Die Amplitude wiederum gibt die Intensität des Schalls (Schalldruck, Lautstärke) wieder.

Sprachliche Laute gehören zu einem speziellen Typ von Schallschwingungen, nämlich den Klängen. Im Gegensatz zu Geräuschen sind Klänge periodische Schallschwingungen, sogenannte Sinoidalschwingungen. Im Gegensatz zu reinen Tönen (z. B. aus der Musik) sind sprachliche Laute jedoch zusammengesetzte Schallschwingungen. Diese zusammengesetzten Schwingungen sind in einzelne Sinoidalschwingungen zerlegbar. Bei einer solchen Zerlegung werden die Amplituden der einzelnen Teilschwingungen ermittelt. So erhält man ein Schallspektrum, und das Verfahren, das hierfür verwendet wird, nennt man Frequenzanalyse oder Fourier-Analyse (nach dem französischen Mathematiker Jean Baptiste Joseph Fourier).

Akustik der gesprochenen Sprache

Bei der Erzeugung sprachlicher Laute unterscheidet man in der akustischen Phonetik zwischen zwei Phasen:

- Erzeugung des Rohschalls: Der Rohschall entsteht entweder durch die Verwirbelungen der Luft, wenn der Luftstrom von der Lunge durch den Kehlkopf mit Glottis und Stimmlippen und weiter durch Mund und Nase strömt. Bei stimmhaften Lauten (Vokalen und stimmhaften Konsonanten) entstehen Verwirbelungen des Luftstroms, also Schwankungen des Luftdrucks, weil sich die vibrierenden Stimmlippen zyklisch öffnen und schließen. Hier spricht man auch von der Stimmtonerzeugung. Bei stimmlosen Konsonanten entstehen Verwirbelungen durch Engstellen, die der Luftstrom auf dem Weg von der Glottis bis zum Mund- und Nasenausgang passieren muss, z. B. durch die Glottis oder durch (fast) geschlossene Lippen. Dieser erzeugte Rohschall wird dann auch als Rauschen bezeichnet.

- Modulation des Rohschalls: Der Rohschall wird im Rachen- und Nasenraum moduliert, und zwar abhängig von der Position der Artikulationsorgane wie Kiefer, Zunge und Lippen.

Beim Flüstern werden selbst die Vokale nur durch Modulation des Spektrums des Rauschens eines hervorgepressten Luftstromes gebildet, während die Stimmbänder keine Rolle spielen.

Im Zusammenhang mit der Beschreibung der Sprachschallproduktion ist das Quelle-Filter-Modell (oder die Quellen-Filter-Theorie) ein wichtiges Modell der akustischen Phonetik. Die Quellen-Filter-Theorie der Lautproduktion hatte der deutsche Physiologe Johannes Müller 1848 aufgebracht. Die Quelle-Filter-Theorie oder das Quelle-Filter-Modell ist eine Modellierung der Vokalartikulation. Sie gibt auf vereinfachte Weise wieder, wie der Schall von Vokalen erzeugt wird. Das Modell geht von einer Quelle des Rohschalls aus, wie etwa die Stimmlippen. Auf seinem Weg durch den Bereich zwischen Glottis und Lippen, dem sogenannten Ansatzrohr, wird der Rohschall modifiziert. Das Ansatzrohr funktioniert als Filter für den Rohschall. Die Quelle-Filter-Theorie geht auf die Arbeit von Gunnar Fant zurück, der damit ein Modell entwickelte, das den Zusammenhang zwischen den akustischen Eigenschaften eines Vokals und der Form des Vokaltrakts zeigt.

Die Quelle-Filter-Theorie ist sowohl für die akustische Sprachanalyse als auch für die Sprachsynthese grundlegend. Nach der Quelle-Filter-Theorie lassen sich Vokale recht einfach synthetisch erzeugen, indem man zuerst ein Klangspektrum mit ungegliederter spektraler Hüllkurve erzeugt und dieses Klangspektrum durch eine Reihe von Bandpassfiltern schickt.

Visuelle Darstellung von Sprachsignalen

Die akustische Phonetik hat verschiedene Verfahren entwickelt, um Sprachsignale visuell darzustellen. Dahinter steht das Ziel, die akustischen Eigenschaften sprachlicher Laute exakter zu erfassen und beschreiben zu können. Dazu zählen unter anderem die Verwendung des Oszillographen, um Frequenz und Amplitude über die Zeit darzustellen, sowie der Einsatz eines Sonagraphen zur Erstellung von Schall-Spektrogrammen (oder Sonagrammen).

Methoden der visuellen Darstellung

Die akustische Phonetik verwendet verschiedene Methoden, um die Akustik der sprachlichen Äußerungen zu visualisieren. Eine wichtige Darstellungsform ist das Oszillogramm, das die Schallschwingungen als Graph entlang einer Zeitachse darstellt. Das Oszillogramm gibt den tatsächlichen Schwingungsvorgang des Schalls wieder, misst also die Schwingung der Luftteilchen während der Schallwellenübertragung. Auf dem Oszillogramm kann man unter anderem die Frequenz und die Amplitude der Schallwellen ablesen.

Aus dem Oszillogramm ergeben sich unter anderem Hinweise auf die Silbenstruktur der sprachlichen Äußerung und die Sprechmelodie. Auch kann man mit einem Oszillogrammm zwischen Tönen, Klängen, Geräuschen, Rauschen und Knall gut unterscheiden. Häufig will man jedoch nicht nur die reinen Schallschwingungen darstellen, sondern noch detailliertere Analysen vornehmen wie die Unterscheidung zwischen verschiedenen Vokalen wie [a] und [e], die sich auf dem Oszillogramm kaum unterscheiden.

In diesem Fall kommen andere Methoden zum Einsatz: So kann man die akustische Information der Schallschwingungen mittels mathematischer Methoden wie die Fourier-Transformation in ein Spektrogramm (Sonagramm) umwandeln. Auf einem Sonagramm kann man Frequenzen und Amplituden der Schallwellen einer sprachlichen Äußerung sowie Zeit gleichzeitig betrachten. Im Sonagramm ist der Zeitverlauf auf der x-Achse (von links nach rechts), während die Frequenz auf der y-Achse (von unten nach oben) dargestellt wird. Die Amplitude der Schallwellen wird durch verschiedene Grauschattierungen dargestellt: je dunkler ein Bereich, desto größer die Amplitude.

Je nachdem, ob auf einem Spektrogramm entweder die Zeit gut auflöst oder die Frequenz gut auflöst, spricht man von unterschiedlichen Spektrogramm-Typen: Beim Schmalband-Spektrogramm sind relativ kleine Frequenzunterschiede gut erkennbar, während beim Breitbandspektrogramm die Zeit gut aufgelöst ist. Das Spektrogramm ist eine der wichtigen Darstellungsformen in der akustischen Phonetik. Da man jedoch auch Analysen machen will, in denen sowohl Zeit als auch Frequenz gut aufgelöst sind, sind noch weitere Darstellungen des Sprachsignals dazugetreten, etwa Wavelets, Gabor-Spektren und auditive Spektren.

Formanten

Ein wichtiges Konzept aus der akustischen Phonetik ist der Formant, der sich auf Sonagrammen gut darstellen lässt: Formanten entstehen in den Resonanzspektren der menschlichen Stimme. Aufgrund der Resonanzeigenschaften des menschlichen Artikulationsraums werden bestimmte Frequenzbereiche im Verhältnis zu anderen Frequenzbereichen verstärkt. Formanten sind dabei diejenigen Frequenzbereiche, bei denen die relative Verstärkung am höchsten ist. Formanten sind im Sonagramm als waagerechte Frequenzbänder mit dem höchsten Schwärzungsgrad erkennbar. Im Sonagramm sind die Formanten also die grafische Repräsentation des Vokalschalls.

Man kann die akustischen Eigenschaften der Vokale mithilfe der Formanten beschreiben. Für die Eigenschaften der Vokale sind vor allem die Formanten F1 und F2 verantwortlich, zu einem geringen Teil auch F3 und F4. Vereinfacht entsprechend den Formanten folgende Frequenzen und Resonanzräume:

| Formant | Frequenzspektrum (männlich) |

Zugeordneter Resonanzraum |

|---|---|---|

| F0 | 00080–0200 Hz | Stimme (Kehlkopf) |

| F1 | 00220–0780 Hz | Rachen |

| F2 | 01200–2000 Hz | Lippenraum |

| F3 | 02200–3000 Hz | Mundraum |

| F4 | 03350–4150 Hz | Koronalraum |

Segmentierung des Sprachsignals in einzelne Laute

Eine wichtige Erkenntnis der akustischen Phonetik ist, dass sich aufgezeichnete Sprachsignale, die anschließend visuell z. B. in einem Sonagramm dargestellt werden, nicht auf einen Blick in einzelne, klar abgrenzbare Sprachlaute aufteilen lassen. So kann man zwar auf einem Sonagramm unterschiedliche akustische Segmente erkennen, aber diese lassen sich nicht eindeutig den Lautsegmenten zuordnen, die man durch die Transkribierung einer Äußerung in Lautschrift erhält. Bernd Pompino-Marschall zitiert in seiner Einführung den amerikanischen Linguisten Charles Hockett, der beim Anblick eines Sonagramms gesagt hätte, dass die Sprachlaute wie eine Reihe Ostereier aussähen, die man durch die Mangel gedreht hätte.

Kombiniert man jedoch die verschiedenen visuellen Darstellungsmöglichkeiten für sprachliche Äußerungen (Oszillogrammm, Breitband- und Schmalbandsonagramme), so kann man akustische Sprachsignale durchaus weiter optisch segmentieren, zum Beispiel:

- Stimmhafte Abschnitte lassen sich im Breitband durch klare vertikale Strichmusterungen erkennen, während stimmlose Abschnitte unregelmäßig strukturiert sind.

- Die Frequenzlage stimmloser Abschnitte erkennt man an der unregelmäßig strukturierten Schwärzung.

- Im Breitbandsonagramm findet man die Formantfrequenzen als geschwärzte Bänder, womit die Vokale beschrieben sind.

- Frikative wie [s] oder [f] sind aufgrund ihrer Lage als unregelmäßig strukturierte Schwärzung erkennbar.

Übergänge zwischen den eigentlichen Lauten, insbesondere den Vokalen, werden als Transitionen, Formantverschiebungen oder Formantabbiegungen (englisch formant transitions) bezeichnet.

Literatur

- Fabian Bross: Grundzüge der Akustischen Phonetik. In: Helikon. A Multidisciplinary Online Journal. Nr. 1, 2010, S. 89–104 (Online; PDF; 1,3 MB).

- Peter Ladefoged: Elements of Acoustic Phonetics. 2. Auflage. University of Chicago Press, Chicago 1996, ISBN 0-226-46764-3.

- Bernd Pompino-Marschall: Einführung in die Phonetik. 3. Auflage. De Gruyter, Berlin 2009, ISBN 3-11-022480-1.

- George A. Miller: Wörter. Streifzüge durch die Psycholinguistik. Herausgegeben und aus dem Amerikanischen übersetzt von Joachim Grabowski und Christiane Fellbaum. Spektrum der Wissenschaft, Heidelberg 1993; Lizenzausgabe: Zweitausendeins, Frankfurt am Main 1995; 2. Auflage ebenda 1996, ISBN 3-86150-115-5, S. 83–108 (Das gesprochene Wort).

- Joachim M.H. Neppert: Elemente einer Akustischen Phonetik. 4. Auflage. Hamburg 1999, ISBN 3-87548-154-2.

- Henning Reetz: Artikulatorische und Akustische Phonetik. Wissenschaftlicher Verlag, Trier 2003, ISBN 3-88476-617-1.